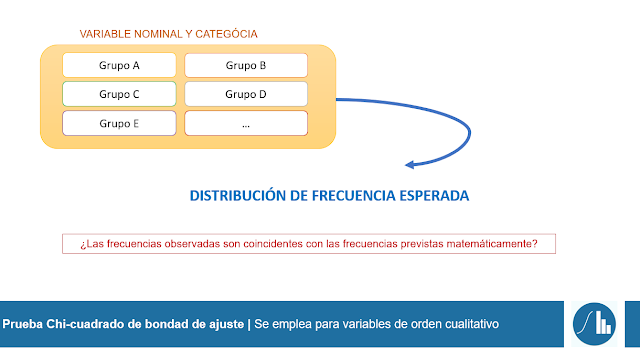

En la entrada anterior hemos visto que el análisis de bondad de ajuste Chi-cuadrado sirve para analizar y comparar la frecuencia observada con la frecuencia esperada de una variable cualitativa nominal. ¿Qué pasa cuando queremos analizar la relación entre dos variables cualitativas? Pues que tenemos que realizar la prueba Chi-cuadrado de independencia (Chi-square test of Independence en inglés), también conocido como Chi-cuadrado de Pearson o Chi-cuadrado de asociación.

Prueba Chi-cuadrado de independencia

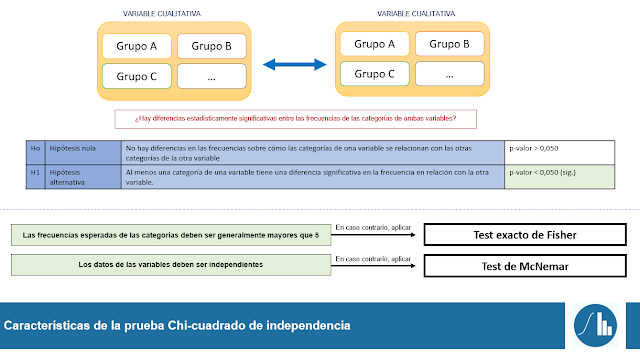

Al igual que ocurre con la prueba T de Student o el ANOVA de un factor, la prueba chi-cuadrado de independencia es un contraste de hipótesis que se usa para comparar diferencias significativas en las frecuencias de dos variables categóricas.

Puesto que tenemos dos variables cualitativas categóricas (ya sean nominales u ordinales) con distintas categorías o tipos, se suele declarar el número de categorías que tiene cada una de las variables objeto de estudio. Es decir, es muy habitual expresar este análisis como una prueba Chi-cuadrado z · y (en donde z es el número de categorías de la variable A e y es el número de categorías de la variable B). En la siguiente ilustración se muestran las hipótesis estadística de partida de dicha prueba, que se deberán adaptar a las características particulares de cada experimento:

Tal y como se aprecia en la imagen anterior, para realizar el test Chi-cuadrado de independencia ambas variables cualitativas categóricas deben tener una frecuencia esperada grande (normalmente mayor de 5) y los datos deben ser independendientes (de ahí el nombre de la prueba).

Caso práctico

Una de las partes de un estudio psicológico era pedir la fruta favorita de los participantes. El objetivo de esta pregunta es averiguar si hombres y mujeres tienen preferencias similares a la hora de elegir la fruta que desean comer. Para ello, se ha recogido información de 57 personas distintas que aceptaron participar en dicho estudio.

De todos los datos que se han extraído de la investigación, solo dos variables cualitativas se van a poner en una base de datos de Jamovi (formato .omv) denominada Fruta favorita: sexo (categorizado por hombre y mujer) y fruta (categorizado por plátano, kiwi, sandía, melón, melocotón, naranja, mandarina, piña, fresas, pera y manzana). Ambas son variables cualitativas nominales, por lo que todo indica que se debe hacer una prueba Chi-cuadrado de independencia 2 · 11 (2 categorías de la primera variable · 11 de la segunda). Se puede acceder a los datos haciendo clic en el siguiente botón. El análisis se realizará en el software Jamovi (versión 2.3.28) en un ordenador Windows 10. No obstante, se recuerda que este mismo procedimiento se puede realizar en un ordenador Mac.

Procedimiento

Este tipo de prueba implica que debamos "personalizar" el contraste de hipótesis en función de la naturaleza de nuestras variables.

- Hipótesis nula [Ho]. Ambos sexos tienen preferencias similares a la hora de escoger una fruta.

- Hipótesis alternativa [H1]. Ambos sexos tienen preferencias distintas a la hora de escoger una fruta.

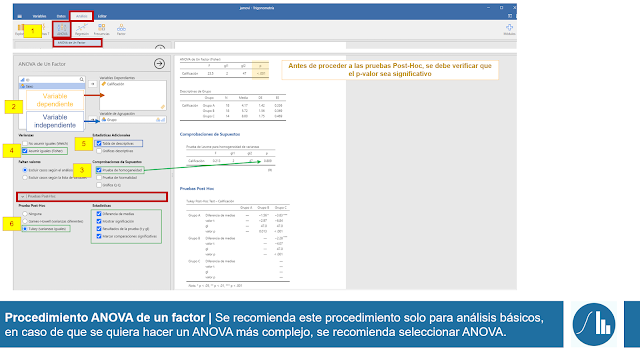

En primer lugar, debemos acceder a la opción de Chi-cuadrado de independencia. Para ello, debemos estar en el menú de Análisis, hacer clic sobre el icono de Frecuencias y hacer clic sobre Muestras independientes: Prueba de asociación X2. En la siguiente ventana de la izquierda deberemos trasladar nuestras dos variables objeto de estudio a las Filas y Columnas. La colocación de cada variable en filas o columnas de la tabla de contingencia no influye en absoluto en el análisis. Sin embargo, se recomienda colocar en las filas, la variable que más categorías o grupos tenga (Futa en este caso).

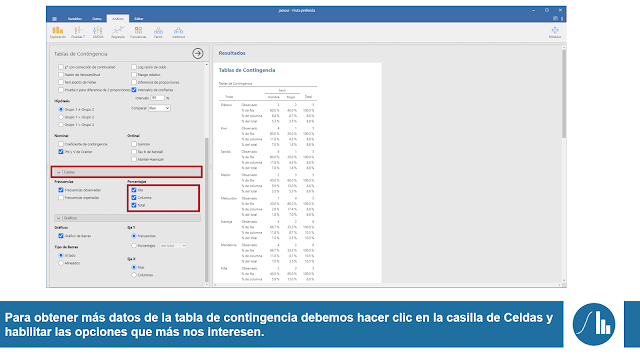

A continuación, debemos verificar el supuesto de que las frecuencias esperadas sean mayores que 5. Para ello, hacemos clic en la ventana de Celdas y hacemos clic sobre la ventana de Frecuencias esperadas. Si cada una de las frecuencias esperadas es mayor de 5, podemos continuar con nuestro análisis.

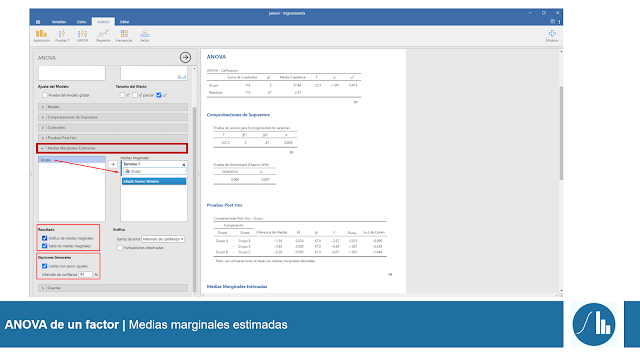

Entonces, para solicitar la prueba Chi-cuadrado de independencia, hacemos clic en la casilla de Estadísticas. A continuación, nos aseguramos que la opción X2 del apartado Pruebas esté marcada. Además, solicitaremos el tamaño del efecto de Phi y V de Cramer en el apartado de Nominal, tal y como se muestra en la siguiente imagen. Opcionalmente, se puede solicitar en el apartado de Gráficos el Gráfico de Barras.

Resultados

En primer lugar debemos verificar la hipótesis que se confirma. Para ello, nos debemos fijar en el p-valor de la tabla X2 y determinar con qué hipótesis nos quedamos. A continuación, si el p-valor es inferior a 0,050 se deberá estudiar el tamaño del efecto. Tal y como se puede ver en la siguiente imagen, la V de Cramer se interpreta como la fuerza de la relación entre ambas variables: cuanto más cerca esté de 0 la relación es mas débil y cuanto más cerca esté de 1 dicha relación será más sólida. Nótese que el coeficiente de Phi no se reporta puesto que se precisa que el número de categorías entre una y otra variable sea perfecto: por ejemplo, 3 . 3 o 5 · 5.

En este ejemplo el p-valor es 0,658; lo que significa que se debe apoyar la hipótesis nula de que no hay diferencias significativas entre la variable sexo y la preferencia de frutas. Por tanto, no tiene sentido seguir analizando el tamaño del efecto V de Cramer (que aún así da un valor cercano a 0; que significa que la fuerza de la relación es muy débil).

Redacción e interpretación final

En este tipo de análisis es muy habitual reportar los resultados en forma de tabla de contingencia o tabla de doble entrada. Dentro de ella se suelen poner la frecuencias o los porcentajes para cada una de las categorías de la variable. Además, también se suele reportar el estadístico completo acompañado de los grados de libertad, el p-valor y el tamaño del efecto.

Para redactar el párrafo de resultados se recomienda la siguiente estructura. En azul las partes que se deben adaptar a cada uno de los casos particulares:

- El test de independencia X2 de Pearson (no) mostró una asociación significativa entre la variable nominal A y la variable nominal B (X2 (grados de libertad) = estadístico; p-valor; tamaño del efecto). Se observa que es más probable que la categoría Z de la variable A (porcentaje) prefiera la categoría N de la variable B (porcentaje) que la categoría X de la variable A (porcentaje).

- Pearson's X2 of independence (did not) showe(d) a significant association between nominal variable A and nominal variable B (X2 (degrees of freedom) = statistic; p-value; effect size). Category N of the variable A (percentage) was more likely to prefer category N of variable B (percentage) compared to category X of the variable A (percentage).

Jacob Sierra Díaz y Alti